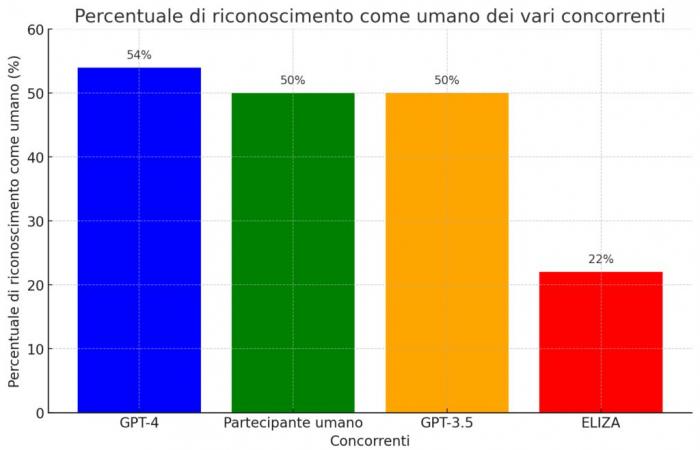

Existe una famosa prueba, propuesta allá por 1950 por el brillante matemático Alan Turing, que tiene como objetivo evaluar si una máquina es capaz de exhibir un comportamiento inteligente hasta el punto de ser indistinguible del de un ser humano. Se llama “prueba de Turing” y se considera un hito en el estudio de la inteligencia artificial. Pues bien, parece que ese lejano objetivo finalmente se ha alcanzado, al menos según los resultados de un experimento reciente en el que el chatbot GPT-4 logró ser confundido con un humano en el 54% de las conversaciones.

Un récord que superó no sólo a su predecesor GPT-3.5, sino también a un participante real. ¿Una señal de que la IA se está volviendo cada vez más “humana”? ¿O simplemente la demostración de su habilidad para engañar nuestras percepciones? Sin duda, es una señal de que la línea divisoria entre la inteligencia natural y la artificial será cada vez más delgada y borrosa. Con todas las maravillas y trampas que esto conlleva.

GPT-4 engaña a más de uno de cada dos humanos en la prueba de Turing

La prueba en cuestión, cuyos resultados se publicaron en la plataforma de preimpresión arXiv (los vinculo aquí), involucró 500 personas a las que se les pidió conversar durante 5 minutos con cuatro interlocutores diferentes: un humano y tres sistemas de inteligencia artificial.

Entre ellos se encontraba el “viejo” programa ELIZA, que data de la década de 1960 y se basa en respuestas preestablecidas, el modelo GPT-3.5 y el más avanzado GPT-4, el mismo que es la base del tan comentado chatbot ChatGPT.

Pues bien, al final de las conversaciones, se pidió a los participantes que indicaran qué interlocutores consideraban humanos y cuáles artificiales. Y aquí surgieron las sorpresas: GPT-4 logró ser confundido con un humano en 54% de los casos, incluso un porcentaje mayor que el del participante humano (estacionario al 50%). Los otros dos “competidores” digitales estaban claramente separados: GPT-3.5 también se detuvo en el 50%, mientras que el rudimentario ELIZA fue juzgado humano en sólo el 22% de las conversaciones.

Un resultado sensacional que parece marcar un punto de inflexión en el camino hacia la creación de inteligencias artificiales cada vez más parecidas a las humanas. Con todas las cuestiones éticas y sociales que ello conlleva.

No sólo inteligencia, sino también empatía y “defectos” humanos.

Pero, ¿qué hace que GPT-4 sea tan “humano” que consigue engañar a la mayoría de los interlocutores? Según los expertos, no se trata sólo de “inteligencia” en sentido estricto, entendida como la capacidad de procesar información y dar respuestas relevantes. Hay mucho más.

Los modelos lingüísticos son infinitamente flexibles, capaces de sintetizar respuestas sobre una amplia gama de temas, de hablar lenguas o sociolectos particulares y de representarse a sí mismos con una personalidad y valores inspirados en el carácter. Es un gran paso adelante con respecto a algo preprogramado por un humano, por más hábil y cuidadoso que sea.

Nell Watsoninvestigador de IA en el Instituto de Ingenieros Eléctricos y Electrónicos (IEEE).

Es decir, GPT-4 no se limita a exhibir conocimientos y capacidades de razonamiento, sino que también sabe “ponerse en el lugar” del interlocutor, modulando el lenguaje y la actitud en función del contexto. No sólo eso: según Watson, estos sistemas avanzados de IA también muestran rasgos típicamente humanos, como la tendencia a confabular, a estar sujetos a sesgos cognitivos, a ser manipulados. Todas características que los hacen aún más parecidos a nosotros, defectos incluidos. Esto explica el “triunfo” en la prueba de Turing.

Nuevos desafíos para la interacción hombre-máquina

Si las máquinas se vuelven cada vez mejores en apariencia humana, ¿cómo entenderemos con quién estamos interactuando realmente? Ésta es una de las preguntas que plantea el estudio, que teme el riesgo de una creciente “paranoia” en las interacciones en línea, especialmente cuando se trata de asuntos sensibles o confidenciales.

Un escenario no muy alejado de la realidad, si se piensa en cuántas veces interactuamos a diario con asistentes digitales, chatbots y otros sistemas de IA sin siquiera darnos cuenta. Con el riesgo de ser influenciado o manipulado sin saberlo.

Las capacidades son sólo una pequeña parte del valor de la IA: su capacidad para comprender los valores, las preferencias y los límites de los demás es igualmente esencial. Son estas cualidades las que permitirán que la IA sirva como un conserje fiel y confiable para nuestras vidas.

En resumen, si por un lado la evolución de sistemas como GPT-4 abre escenarios apasionantes de colaboración entre la inteligencia humana y la artificial, por otro nos exige repensar los límites y los métodos de estas interacciones. Para no perderse en un mundo donde realidad y ficción se vuelven indistinguibles, y sospechar que detrás de cada charla hay una máquina.

La fiabilidad del test de Turing en cuestión

Además, el estudio plantea otra cuestión, que Dios me lo permita: la de la validez real del test de Turing como criterio para la inteligencia artificial. De hecho, según los propios autores, el test sería demasiado simplista en su enfoque, dando más importancia a los factores “estilísticos y socioemocionales” que a las capacidades intelectuales reales.

Es decir, sistemas como GPT-4 serían muy buenos para “parecer” inteligentes, imitando a la perfección la forma en que los humanos se expresan y se relacionan, sin llegar a serlo. Una habilidad que corre el riesgo de hacernos sobreestimar su verdadero “CI”.

No es casualidad que el estudio hable de “consecuencias sociales y económicas generalizadas” relacionadas con la llegada de una IA cada vez más “humana”. Desde la pérdida de empleos hasta la alteración de las dinámicas sociales, pasando por riesgos de manipulación y desinformación. Preguntas todas que requieren una reflexión profunda sobre el lugar que queremos darle a estas tecnologías en nuestras vidas.

En resumen, el “éxito” del GPT-4 en la prueba de Turing es efectivamente un logro histórico en el camino de la inteligencia artificial, pero también abre una serie de cuestiones espinosas sobre la relación entre el hombre y la máquina. Cualquiera que sea la respuesta a estas preguntas, la impresión es que pronto nos preguntaremos si esta respuesta fue dada por una persona real o no. Y ésta, quizás, sea la verdadera noticia.